Pourquoi nous avons mis l'IA en pause (pour revenir aux fondamentaux)

Quand on lance une startup Tech en 2025, la tentation est grande de mettre de l'"IA" et du Machine Learning partout. C'est vendeur, c'est "hype", et ça flatte l'ego technique.

C'est exactement le piège dans lequel je suis tombé avec Momentum Coach. Je voulais construire le coach numérique le plus avancé du marché. Résultat ? J'ai réalisé que la complexité n'est pas toujours la réponse. J'ai choisi de bâtir Momentum Coach sur une base méthodologique éprouvée (VDOT), gardant l'IA pour ce qu'elle fait de mieux : l'optimisation à la marge.

Voici l'histoire technique de ce pivot, et pourquoi la simplicité gagne toujours, même face aux algorithmes les plus sophistiqués.

1. L'Approche "Ingénieur" : Le Filtre de Kalman

Mon idée initiale était de traiter la condition physique d'un athlète comme un système dynamique observable.

L'ambition était majeure : au lieu de demander à l'utilisateur de faire un test initial, je voulais estimer son profil physiologique complet (VO2max, Seuil Anaérobie) simplement en analysant son historique Strava (les "Big Data").

En théorie du signal, quand on veut estimer l'état caché d'un système (ici, le niveau physio) à partir de mesures imparfaites (les footings du dimanche), l'outil roi est le Filtre de Kalman.

La Théorie

Le modèle se base sur deux équations matricielles :

-

L'Équation d'État (Prediction) :

- : L'état de forme au jour (Fitness & Fatigue).

- : La charge d'entraînement (Training Impulse - TRIMP).

- : Matrices de transition (comment la forme évolue naturellement et comment l'entraînement l'impacte).

- : Bruit du processus (stress de la vie, maladie...).

-

L'Équation de Mesure (Update) :

- : La performance observée (ex: allure cardiaque sur un footing).

- : Bruit de mesure (GPS imprécis, dérive cardiaque, chaleur...).

La Promesse : "Live & Continuous Update"

La grande force théorique de ce modèle est sa capacité à se mettre à jour en continu, sans nouveau test maximal. L'algorithme ingère chaque sortie :

- Si vous courez votre footing habituel à 10km/h mais avec 5 puls/min de moins que d'habitude...

- Le filtre détecte une réduction de l'erreur entre la prédiction et la mesure.

- Il met à jour sa "Croyance" : votre endurance fondamentale s'est améliorée -> votre Seuil a augmenté.

C'était le graal : un plan d'entraînement qui s'adapte dynamiquement après chaque séance, même une récupération active. "Automagique".

La Réalité : "Garbage In, Garbage Out"

En pratique, c'était un enfer à calibrer. Le Filtre de Kalman est optimal si le bruit est gaussien et le modèle linéaire. Or, la physiologie humaine n'est ni l'un ni l'autre.

-

Bruit non-gaussien : Le filtre est conçu pour lisser du bruit statistique "normal" (Gaussien). Mais un GPS qui décroche ou un bug cardio ne sont pas du bruit, ce sont des aberrations massives (outliers). Le filtre, fonctionnant sur des moyennes pondérées, se fait "aspirer" par ces valeurs extrêmes au lieu de les ignorer.

-

Manque d'observabilité : La plupart des amateurs font 80% de leurs sorties en endurance fondamentale à basse intensité. Avec ces seules données, il est mathématiquement très difficile (voire impossible) de distinguer une amélioration du VO2max d'une variation de la fatigue ou de la température. Le rapport Signal/Bruit est trop faible sur les footings lents.

J'avais construit une usine à gaz qui essayait de deviner la VMA d'un coureur à partir de ses footings de récupération. C'était instable et frustrant.

2. Le Retour aux Sources : VDOT (Daniels & Gilbert, 1979)

Fatigué de debugger mes matrices de covariance, j'ai ouvert un livre de référence : "Daniel's Running Formula". Le Dr Jack Daniels (physiologiste, médaillé olympique) et le mathématicien Jimmy Gilbert ont publié des travaux fondamentaux qui sont encore aujourd'hui la base de l'entraînement moderne.

Leur approche est aux antipodes du Big Data : Peu de données, mais de la donnée de haute qualité.

La Mathématique du VDOT

Au lieu d'essayer de deviner le niveau, ils le mesurent. Le système repose sur deux régressions fondamentales :

- Le coût en oxygène () d'une vitesse donnée () :

*Cette formule estime combien d'oxygène vous consommez pour courir à une vitesse $v$ (m/min).*

2. Le pourcentage de tenable sur une durée () :

*Cette formule décrit la chute de la capacité à tenir un % de sa puissance max à mesure que le temps passe.*

En combinant ces deux courbes, on obtient le VDOT. Contrairement au VO2max de laboratoire (qui mesure la taille du "moteur"), le VDOT mesure la performance effective. Il encapsule :

- Le VO2max (cardio).

- L'Économie de Course (biomécanique/rendement).

- Le Seuil Lactique (endurance).

C'est un indice de performance composite. Deux coureurs avec le même temps sur 10km ont le même VDOT, même si l'un a un gros moteur et une mauvaise foulée, et l'autre l'inverse. Pour l'entraînement, c'est ce qui compte : leur vitesse est la même.

Le Pouvoir (et les Limites) de l'Extrapolation

La beauté du système Daniels, c'est sa capacité prédictive. Si vous connaissez votre VDOT (via un test court, comme un 1600m), vous pouvez mathématiquement prédire votre allure sur n'importe quelle distance, du 1500m au Marathon.

Attention cependant : C'est une équivalence théorique. Un VDOT calculé sur 1600m a tendance à être optimiste pour un Marathon si l'athlète manque d'endurance. C'est là que Momentum Coach intervient. Le VDOT nous donne votre potentiel physiologique. Le but de notre plan d'entraînement est de construire le volume et la résistance nécessaires pour que vous puissiez tenir ce potentiel sur la distance cible.

3. L'Application Pratique : Le Test 1600m (ou vos courses)

Nous avons donc remplacé notre filtre de Kalman instable par un protocole simple.

Pourquoi 1600m ?

Nous demandons un test de 1600m car c'est :

- Facile à caser : Ça prend moins de 15 minutes échauffement compris.

- Facile à récupérer : Contrairement à un 5km ou 10km à fond, ça ne casse pas l'athlète pour la semaine.

- Suffisant : Mathématiquement, la corrélation est déjà excellente.

Bien sûr, si vous venez de courir un 10km ou un semi-marathon en compétition ("à fond"), nous pouvons utiliser ce chronomètre directement. C'est même encore plus précis pour les longues distances. Mais pour quelqu'un qui démarre un plan, le 1600m est le compromis parfait.

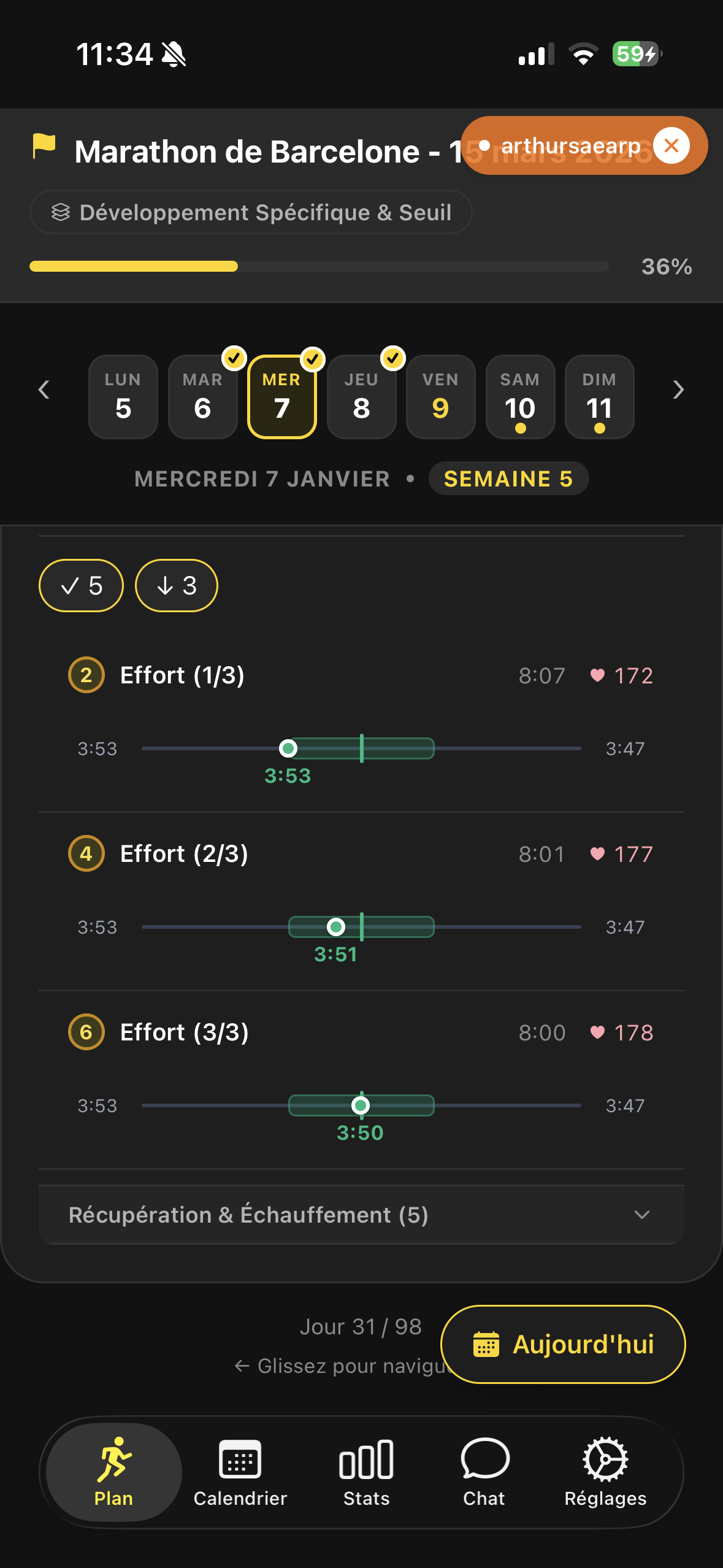

Étude de Cas : Arthur (Marathon de Barcelone)

Arthur, mon associé, a servi de cobaye.

- Test 1600m : Réalisé en 5:50.

- Calcul VDOT : L'algo sort un VDOT de 51.

- Prédiction Seuil : D'après les tables, son allure seuil (Threshold Pace) doit être 3:50/km.

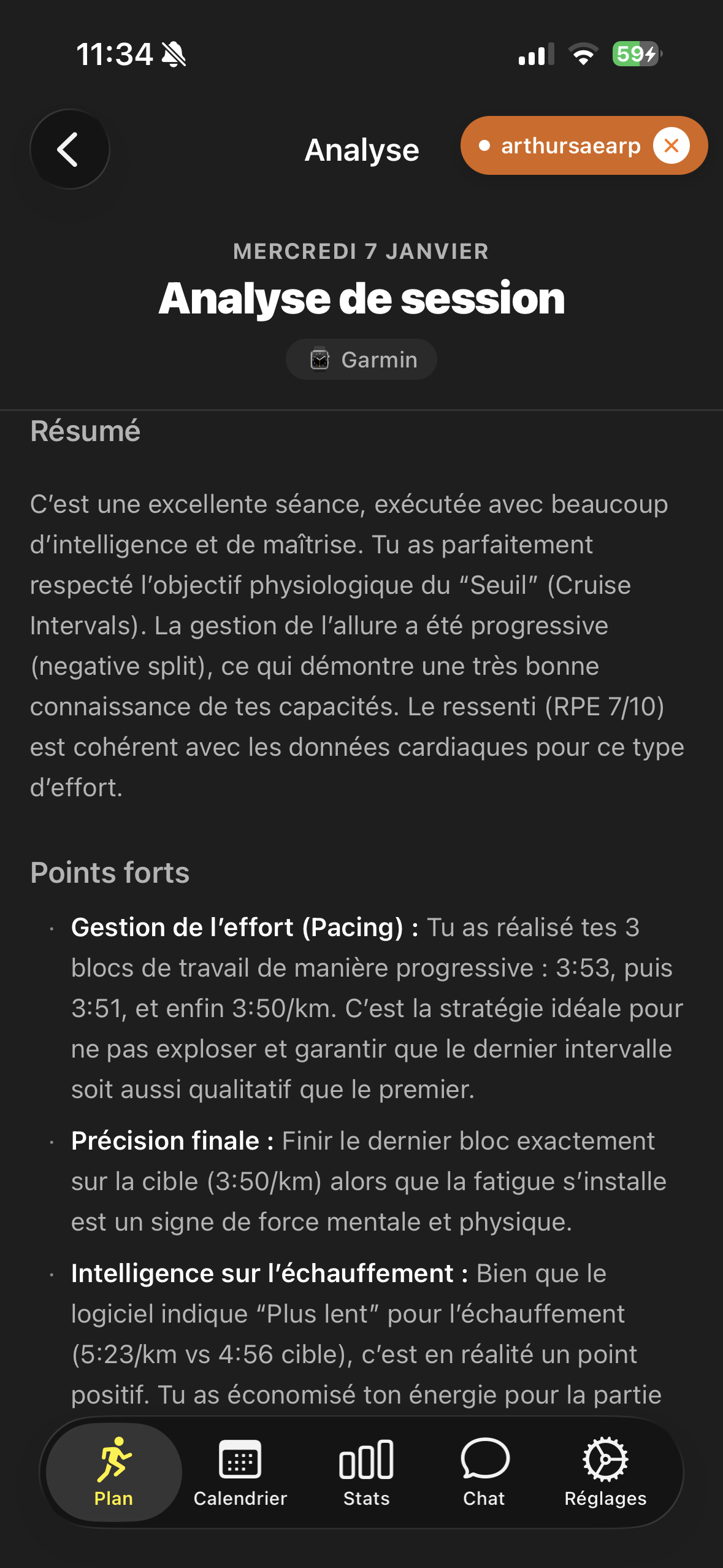

Trois semaines plus tard, séance clé : 3 x 8 minutes au Seuil. Je lui donne une consigne stricte : "Ne regarde pas ta montre. Cours à la sensation (RPE 7-8/10) et au cardio."

Je voulais vérifier si la prédiction mathématique collait à sa physiologie réelle du moment. Les données Strava sont tombées :

- Bloc 1 : 3:53/km

- Bloc 2 : 3:51/km

- Bloc 3 : 3:50/km

La précision est incroyable. Arthur s'est calé naturellement sur l'allure cible, en se fiant uniquement à ses sensations et à sa fréquence cardiaque, sans contrôler son allure en temps réel. Une méthode éprouvée, alimentée par une seule donnée de qualité, a visé juste du premier coup.

Conclusion : Une base solide pour mieux construire le futur

En tant qu'ingénieurs, nous avons tendance à sur-complexifier trop tôt. Ce pivot vers le VDOT ne marque pas la fin de nos ambitions algorithmiques, mais le début d'une approche plus mature.

Utiliser le VDOT nous donne une "Vérité Terrain" solide. Demain, quand nous aurons des milliers d'entrainements labellisés (où l'on connait l'intensité prescrite vs réalisée), nous pourrons réintroduire des filtres de Kalman ou du Machine Learning pour affiner ce modèle. Mais cette fois, l'IA ne devra pas deviner dans le vide : elle aura une base solide pour travailler.

Pour l'instant, nous parions sur la fiabilité. Un test de 6 minutes vaut mieux que 6 mois de données mal interprétées.